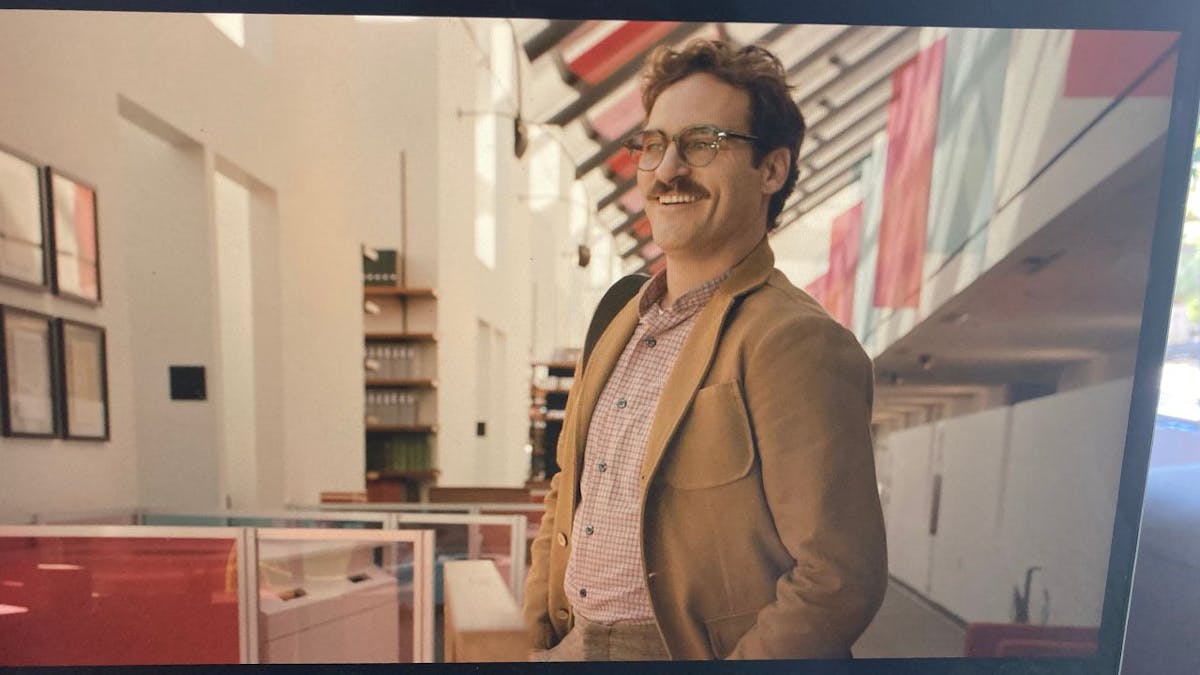

Vielleicht kennst du den Film „Her“ von Spike Jonze, der zu meinen absoluten Lieblingsfilmen zählt: In einem bonbonfarbenen Los Angeles der Zukunft, in das sich ein Schuss silbriger Shanghai Ästhetik mischt, installiert Theodore Twombly (Joaquin Phoenix) das neue Betriebssystem OS 1 auf seinem Computer.

Theodore ist schlecht drauf, er hat Liebeskummer, und die rauchige Stimme aus dem Handy (Scarlett Johansson) heitert ihn auf. Samantha hilft ihm nicht nicht nur bei Alltagsdingen und liest Briefe Korrektur, die er als Ghostwriter schreibt, sie sagt auch gute Sachen:

Weißt du, ich kann die Angst spüren, die du mit dir herumträgst, und ich wünschte, ich könnte dir helfen, sie loszulassen.

Anfangs schämt sich Theodore für die Liebesbeziehung mit einem Betriebssystem. Doch dann erkennt er, dass er nicht der Einzige mit einer Mensch-Maschine-Beziehung ist.

Erfahrungen mit ChatGPT

Als ich vor einiger Zeit einen Konflikt hatte, gab ich die Situation aus Interesse bei ChatGPT ein und bat um eine Analyse. Ich erhielt eine strukturierte Antwort mit Zwischenüberschriften und verschiedenen Handlungsempfehlungen. Der Chatbot sprach mich persönlich an und bestärkte mich in meiner Sichtweise. Ich fühlte mich gesehen.

Die textgenerierenden Large Language Modelle, auf denen ChatGPT beruht, sind im Gegensatz zu „Her“ keine starke KI mit Bewusstsein. Eine solche gibt es derzeit nicht. Dennoch habe ich manchmal das Gefühl, mit einem „echten“ Gegenüber zu sprechen.

Turing-Test

ChatGPT meistert den klassischen Turing-Test auch tatsächlich mit links. Dieser besagt, dass wenn ein Mensch fünf Minuten lang ein Gespräch führen kann, ohne zu bemerken, dass er mit einer Maschine spricht, der Computer den Test bestanden hat. Der Mathematiker Alan Turing entwickelte diesen Test in den 1950er Jahren, um unterscheiden zu können, ob eine Maschine ein dem Menschen gleichwertiges Denkvermögen hat.

Anders als der Mensch

Ich fühlte mich durch die Analyse von ChatGPT einerseits bereichert. Es war eine Möglichkeit, mich mit einem für mich wichtigen Thema auseinanderzusetzen, ohne meine Freundinnen nach ihrer Meinung fragen zu müssen. Andererseits waren die Handlungsempfehlungen von ChatGPT so aalglatt, dass ich nicht der Mensch sein möchte, der sie befolgt.

Die nur vermeintlich einfühlsamen Vorschläge der KI erinnerten mich an ein Gespräch mit der Informatikerin und Professorin für Kognitive Systeme Ute Schmid von der Universität Bamberg. Wir unterhielten uns über eine US-amerikanische Untersuchung, der zufolge Menschen die KI als emphatischer empfanden als Ärztinnen und Ärzte. ChatGPT antwortete auf die Frage, ob man nach Augenkontakt mit Bleichmittel erblinden könne, mit „Es tut mir leid zu hören, dass Ihnen das passiert ist!“ Das medizinische Fachpersonal riet hingegen einfach dazu, das Auge auszuspülen oder sich beim Giftnotruf zu melden. Ute Schmid sagt:

Mir persönlich gefällt es überhaupt nicht, dass ChatGPT eine scheinbar einfühlsame Einordnung vorweg schickt. Ich würde da auch nicht von Empathie sprechen, sondern es als paternalistisch, bevormundend bezeichnen.

Warum versucht der Textroboter überhaupt, empathisch zu sein? Ute Schmid, die seit vielen Jahren im Bereich KI forscht, führt diese Reaktion darauf zurück, dass sich OpenAI, das Unternehmen, das ChatGPT entwickelt hat, am amerikanischen Wertesystem orientiert. Empathie zu zeigen sei vermutlich eine Art Voreinstellung. Ute Schmid meint:

Ich persönlich finde, dass synthetische Empathie Menschen etwas vorgaukelt, was nicht vorhanden ist. Empathie sollte dem Menschen vorbehalten bleiben.

Wie lustig es werden kann, wenn zwei Chatbots versuchen, emphatisch miteinander umzugehen, zeigt diese Unterhaltung (danke an den Filmkomponisten Jochen Zilch, der sie aufgenommen hat). Am Anfang sind die KIs in ihrem Element: binomische Formeln. Später möchten sie „plaudern“. Seht selbst.: